Mammographie : les imprécisions d'un algorithme d'IA selon l'âge ou la race de la patiente

MARDI 21 MAI 2024 Soyez le premier à réagir

Soyez le premier à réagirDans une étude portant sur près de 5 000 mammographies de dépistage interprétées par un algorithme d’IA approuvé par la Food & Drug Administration (FDA), les caractéristiques des patientes telles que la race et l’âge ont influencé des résultats faussement positifs. Les résultats de cette étude ont été publiés dans la Revue Radiology.

Les performances des solutions d’aide à l’interprétation des images médicales construites autour d’algorithmes d’Intelligence Artificielle (IA) suscitent, maintenant que nous avons un peu de recul, certaines interrogations.

Les performances des algorithmes d’IA mise en cause dans le dépistage du cancer du sein

Une étude publiée dans la Revue Radiology et conduite par le Dr Derek L. Nguyen, professeur adjoint à la Duke University de Durham (Caroline du Nord – USA), identifie des dysfonctionnements ponctuels qu’il est nécessaire de prendre en compte. « L'IA est devenue une ressource permettant aux radiologues d'améliorer leur efficacité et leur précision dans la lecture des mammographies de dépistage tout en atténuant l'épuisement des lecteurs, annonce en préambule le Dr Nguyen. Cependant, l'influence des caractéristiques des patients sur les performances de l'IA n'a pas été bien étudiée. »

Une étude publiée dans la Revue Radiology et conduite par le Dr Derek L. Nguyen, professeur adjoint à la Duke University de Durham (Caroline du Nord – USA), identifie des dysfonctionnements ponctuels qu’il est nécessaire de prendre en compte. « L'IA est devenue une ressource permettant aux radiologues d'améliorer leur efficacité et leur précision dans la lecture des mammographies de dépistage tout en atténuant l'épuisement des lecteurs, annonce en préambule le Dr Nguyen. Cependant, l'influence des caractéristiques des patients sur les performances de l'IA n'a pas été bien étudiée. »

Le Dr. Nguyen pense que, même si les données préliminaires suggèrent que les algorithmes d’IA appliqués aux examens de mammographie de dépistage pourraient améliorer les performances diagnostiques des radiologues pour la détection du cancer du sein et réduire le temps d’interprétation, il convient de prendre en compte certains aspects de l’IA.

Une étude qui évalue les décisions de l’IA selon différents sous-groupes de populations

« Il existe peu de bases de données démographiquement diversifiées pour la formation des algorithmes d'IA, et la FDA n'exige pas des ensembles de données diversifiés pour leur validation, ajoute-t-il. En raison des différences entre les populations de patients, il est important de déterminer si les logiciels d’IA peuvent s’adapter et fonctionner au même niveau pour différents âges, races et ethnies de patients. »

« Il existe peu de bases de données démographiquement diversifiées pour la formation des algorithmes d'IA, et la FDA n'exige pas des ensembles de données diversifiés pour leur validation, ajoute-t-il. En raison des différences entre les populations de patients, il est important de déterminer si les logiciels d’IA peuvent s’adapter et fonctionner au même niveau pour différents âges, races et ethnies de patients. »

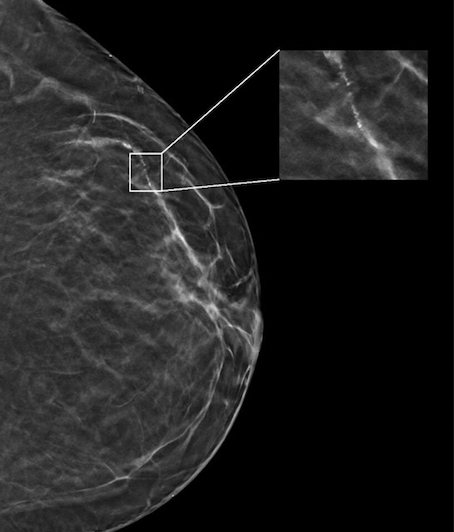

Dans l'étude rétrospective conduite par le Dr Nguyen, les chercheurs ont identifié 5 000 patientes présentant des examens de dépistage du cancer du sein par tomosynthèse négatifs (aucun signe de cancer) effectués au Duke University Medical Center entre 2016 et 2019. Toutes les patientes ont été suivies pendant une période de deux ans après les mammographies de dépistage, et aucune patiente n’a fait l’objet d’un diagnostic de cancer du sein durant cette période.

Un algorithme testé pour l’interprétation de mammographies sur des patientes de plusieurs groupes ethniques

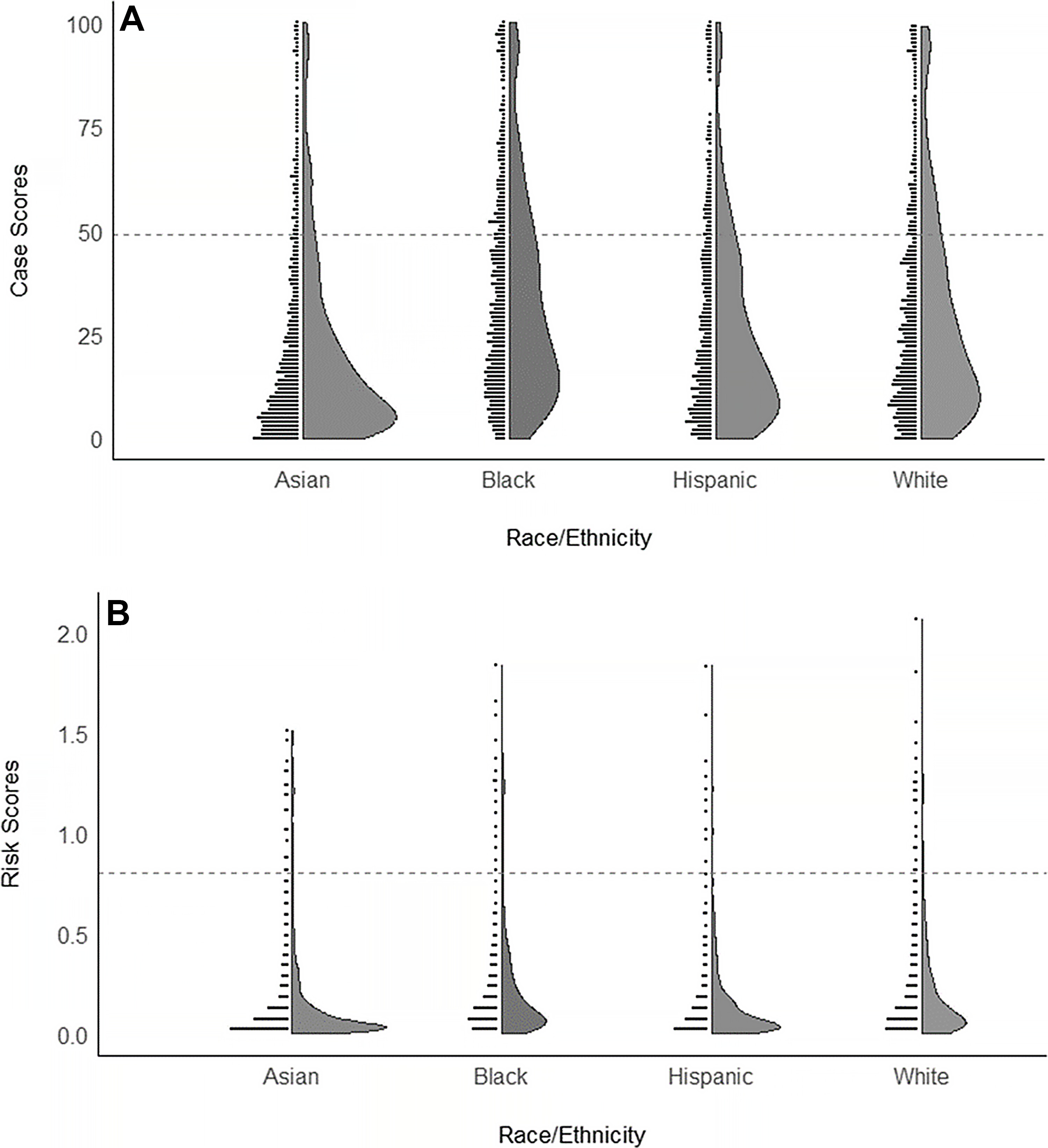

Les chercheurs ont sélectionné au hasard un sous-ensemble de ce groupe composé de 4 855 patientes (âge médian de 54 ans) largement répartis dans quatre groupes ethniques/raciaux. Le sous-ensemble comprenait 1 316 (27 %) patientes blanches, 1 261 (26 %) noires, 1 351 (28 %) asiatiques et 927 (19 %) hispaniques. Un algorithme d'IA disponible dans le commerce a interprété chaque examen du sous-ensemble de mammographies, générant à la fois un score de cas (ou une certitude de malignité) et un score de risque (ou un risque de malignité ultérieur un an).

« Notre objectif était d'évaluer si les performances d'un algorithme d'IA étaient uniformes selon l'âge, les types de densité mammaire et les différentes races/ethnies des patientes », poursuit le Dr Nguyen. Tous les examens de l’étude étant négatifs pour la présence d’un cancer, tout ce qui était signalé comme suspect par l’algorithme a été considéré comme un résultat faussement positif.

Des faux positifs plus nombreux chez les patientes de race noire ou d’âge plus avancé

Les scores de cas faussement positifs étaient significativement plus probables chez les patientes noires et plus âgés (71 à 80 ans) et moins probables chez les patientes asiatiques et les patientes plus jeunes (41 à 50 ans) par rapport aux patientes blanches et aux femmes âgées de 51 à 60 ans.

Les scores de cas faussement positifs étaient significativement plus probables chez les patientes noires et plus âgés (71 à 80 ans) et moins probables chez les patientes asiatiques et les patientes plus jeunes (41 à 50 ans) par rapport aux patientes blanches et aux femmes âgées de 51 à 60 ans.

« Cette étude est importante car elle met en évidence que tout logiciel d'IA acheté par un établissement de santé peut ne pas fonctionner de la même manière selon l'âge, la race, l'origine ethnique et la densité mammaire des patients, commente le Dr Nguyen. À l’avenir, je pense que les mises à niveau des logiciels d’IA devraient se concentrer sur la garantie de la diversité démographique. »

Mieux comprendre le type de population exploré avant d’acquérir un algorithme d’IA

Le Dr. Nguyen exhorte les centres de radiologie à mieux comprendre la population de patients qu’ils explorent avant d’acheter un algorithme d’IA pour l’interprétation des mammographies de dépistage et à interroger les fournisseurs sur la formation de leurs algorithmes.

« Avoir une connaissance de base des données démographiques de votre établissement et interroger le fournisseur sur la diversité ethnique et d'âge de ses données de formation vous aidera à comprendre les limites auxquelles vous serez confronté dans la pratique clinique », conclut-il.

Bruno Benque avec RSNA