Les chercheurs n'ont pas confiance aux chatbots scientifiques

VENDREDI 03 FéVRIER 2023 Soyez le premier à réagir

Soyez le premier à réagirUn nouvel article publié dans la Revue Radiology met en garde contre « l'épée à double tranchant » que constituent les programmes nationaux de traitement du langage basés sur l'intelligence artificielle (IA) comme ChatGPT. Les auteurs donnent quelques conseils pour utiliser ces systèmes avec parcimonie et précision.

ChatGPT, un chatbot avancé, a été lancé par OpenAI à la fin de l'année 2022 et est rapidement devenu populaire, car il répond à des questions complexes avec des réponses de qualité humaine.

Des modèles d’IA de langage virtuel frappés souvent d’effet d’hallucination

ChatGPT est un système d'IA conversationnel lancé par OpenAI, une société de recherche et de déploiement d'IA. Il est basé sur le GPT-3.5, l'un des plus grands modèles de langage virtuel (MLV) (> 175 milliards de paramètres) à ce jour, et a été formé sur un ensemble diversifié de textes Internet (environ 570 Go), parmi lesquels des livres, des articles et des sites Web, et couvrant un large éventail de sujets tels que les actualités, Wikipédia et la fiction. De plus, ChatGPT est spécialement conçu pour les tâches conversationnelles, une fonctionnalité acquise par renforcement à partir du feed-back humain.

Cette technique permet à ChatGPT d'ajuster son comportement en fonction des commentaires des évaluateurs humains. Il est donc bien meilleur pour comprendre les intentions des utilisateurs, générer un texte de type humain et maintenir la cohérence dans une conversation. Mais malgré ces qualités, ChatGPT a plusieurs limites, notamment la production de réponses apparemment crédibles mais incorrectes, telles que l'invention de termes avec lesquels il doit se familiariser. Ce phénomène, connu sous le nom « d'effet d'hallucination », est un problème commun à de nombreux modèles de traitement du langage naturel. De plus, ChatGPT a tendance à suivre les instructions plutôt qu'à s'engager dans une véritable interaction.

Des chatbots pour donner des conseils sur la pertinence des actes ?

Par conséquent, ChatGPT et autres MLV peuvent avoir des répercussions imprévues et devenir une épée à double tranchant. Dans un article publié dans la Revue Radiology, des chercheurs américains discutent des bonnes pratiques d’utilisation de ChatGPT dans le cadre clinique pour augmenter l'efficacité et potentiellement améliorer les soins aux patients, mais donnent également la parole aux chercheurs qui craignent que ChatGPT puisse rédiger de faux articles de recherche susceptibles de tromper les scientifiques et les examinateurs, jusqu’à réduire l'intégrité scientifique des publications.

Par conséquent, ChatGPT et autres MLV peuvent avoir des répercussions imprévues et devenir une épée à double tranchant. Dans un article publié dans la Revue Radiology, des chercheurs américains discutent des bonnes pratiques d’utilisation de ChatGPT dans le cadre clinique pour augmenter l'efficacité et potentiellement améliorer les soins aux patients, mais donnent également la parole aux chercheurs qui craignent que ChatGPT puisse rédiger de faux articles de recherche susceptibles de tromper les scientifiques et les examinateurs, jusqu’à réduire l'intégrité scientifique des publications.

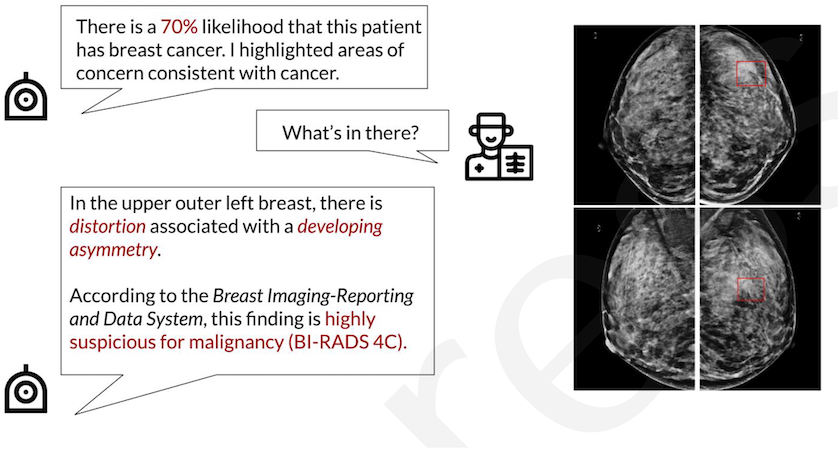

Au cours des dernières années, l'accent a été mis sur l'amélioration de la précision des prescriptions d'examens d'imagerie médicale par les correspondants, via des logiciels d’aide à la décision ou, sur la base du Dossier patient informatisé (DPI), afin d’obtenir une meilleure justification des actes. Alors que la technologie de l'IA montait en puissance, une nouvelle question est apparue : une technologie basée sur l'IA peut-elle fournir des conseils sur la pertinence des actes ?

Des questions imprécises entraînent quelquefois des réponses incohérentes

Les auteurs de l’article suggèrent que les chatbots basés sur l'IA comme ChatGPT peuvent tirer parti de vastes bases de connaissances pour répondre rapidement aux questions concernant la meilleure exploration radiologique dans des scénarios cliniques spécifiques. Cependant, bien qu’il puisse fournir des conseils, il a été conçu pour ne pas offrir de conseils directs aux praticiens. Elle confie souvent la prise de décision médicale aux professionnels de santé dans le respect des règles de sécurité dédiées à sa technologie. De plus, les utilisateurs doivent soigneusement rédiger des questions ou des invites, en fournissant des informations spécifiques sur un scénario clinique et les contre-indications potentielles. Sans invites détaillées ni possibilités de réponse limitées, ChatGPT peut souvent donner des résultats inexacts ou incomplets.

D’autre part, la précision des réponses fournies par une technologie basée sur l'IA dépend de la qualité et du type de données utilisées pour la former. Les prestataires doivent être conscients des biais, des inexactitudes ou de potentielles idées fausses dans ces données. Enfin, l'utilisation d'une technologie basée sur l'IA en dehors d'un DPI peut ne pas cibler les bonnes informations du patient ainsi que les préférences, les capacités et les restrictions relatives à la prescription du correspondant pour faciliter la prise de décision.

« Alors que nous naviguons dans les décisions concernant l'utilisation de technologies basées sur l'IA comme ChatGPT, il est important de procéder avec prudence », écrivent les auteurs. Ils donnent quelques conseils pour les utiliser avec parcimonie et précision.

Bruno Benque avec RSNA