Des modèles pertinents de deep learning pour la radiographie thoracique

Selon une étude publiée dans la revue Radiology, le deep learning peut détecter des résultats de radiographie thoracique cliniquement significatifs aussi efficacement que des radiologues expérimentés. Les chercheurs rapportent que leurs résultats pourraient constituer une ressource précieuse pour le développement futur de modèles d’intelligence artificielle pour la radiographie thoracique.

La radiographie thoracique a, depuis longtemps atteint ses limites en termes de diagnostic, notamment depuis la généralisation du scanner. Il n’empêche que cet examen a toujours son utilité et reste celui qui est le plus pratiqué dans le monde.

Des modèles combinant des données du Royaume-Uni et d’Inde

« Nous avons constaté que l’interprétation des radiographies du thorax est très subjective, a déclaré Shravya Shetty, responsable de l’ingénierie chez Google Health à Palo Alto, en Californie et co-auteur d’une étude publiée dans la Revue Radiology. Une variabilité significative entre les lecteurs et une sensibilité non optimale pour la détection de résultats cliniques importants peuvent limiter son efficacité. » Le deep learning a le potentiel d'améliorer l'interprétation des radiographies du thorax, mais il a aussi des limites. Par exemple, les résultats obtenus d'un groupe de patients ne peuvent pas toujours être généralisés à la population en général.

« Nous avons constaté que l’interprétation des radiographies du thorax est très subjective, a déclaré Shravya Shetty, responsable de l’ingénierie chez Google Health à Palo Alto, en Californie et co-auteur d’une étude publiée dans la Revue Radiology. Une variabilité significative entre les lecteurs et une sensibilité non optimale pour la détection de résultats cliniques importants peuvent limiter son efficacité. » Le deep learning a le potentiel d'améliorer l'interprétation des radiographies du thorax, mais il a aussi des limites. Par exemple, les résultats obtenus d'un groupe de patients ne peuvent pas toujours être généralisés à la population en général.

Les chercheurs de Google Health ont développé des modèles de deep learning dans ce cadre, permettant de surmonter certaines de ces limitations. Ils ont utilisé deux grands ensembles de données pour développer, former et tester les modèles. Le premier ensemble de données comprenait plus de 750 000 images provenant de cinq hôpitaux en Inde, tandis que le second ensemble comprenait 112 120 images mises à la disposition du public par le National Institutes of Health (NIH).

Des résultats identiques aux radiologues pour certaines images significatives

Un groupe de radiologues s'est réuni pour créer les annotations d’images pour certaines anomalies visibles sur les radiographies thoraciques utilisées pour former les modèles. « L'interprétation des radiographies thoraciques est souvent une évaluation qualitative, ce qui pose problème du point de vue du deep learning, poursuit Daniel Tse, chef de produit chez Google Health. En utilisant un champ plus large et plus diversifié de données de radiographie thoracique et en les évaluant par panel, nous avons pu produire des modèles plus fiables. »

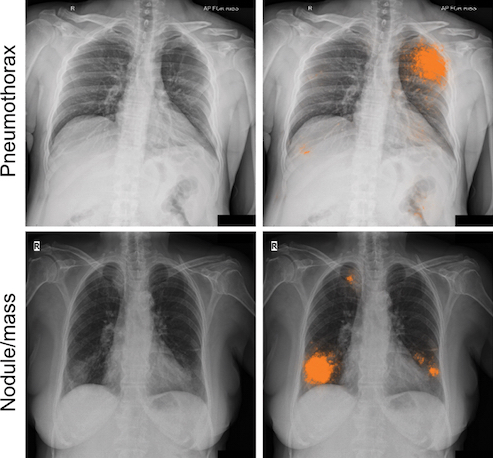

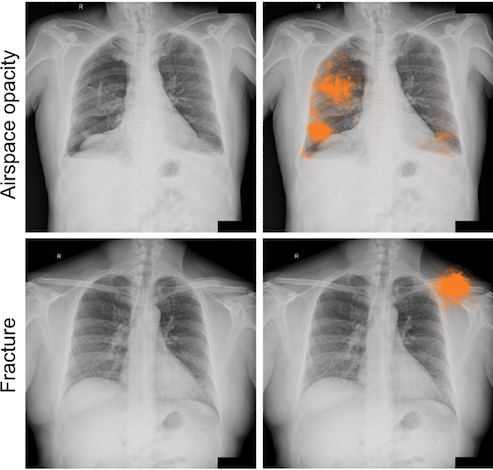

Les tests des modèles de deep learning ont montré que leurs résultats étaient comparables à ceux des radiologues en détectant quatre types d’images significatives sur les radiographies thoraciques de face : fractures, nodules ou masses, opacités et pneumothorax. L’évaluation des radiologues a conduit à un consensus plus évolué des experts sur les annotations utilisées pour le paramétrage du modèle et sur l'évaluation de la performance. Le consensus global est passé d’un peu plus de 41% après la lecture initiale à plus de 97% après l’utilisation de la nouvelle cohorte.

Les tests des modèles de deep learning ont montré que leurs résultats étaient comparables à ceux des radiologues en détectant quatre types d’images significatives sur les radiographies thoraciques de face : fractures, nodules ou masses, opacités et pneumothorax. L’évaluation des radiologues a conduit à un consensus plus évolué des experts sur les annotations utilisées pour le paramétrage du modèle et sur l'évaluation de la performance. Le consensus global est passé d’un peu plus de 41% après la lecture initiale à plus de 97% après l’utilisation de la nouvelle cohorte.

Développer des modèles d'intelligence artificielle cliniquement utiles pour la radiographie thoracique

Les techniques d'évaluation de modèle rigoureuses présentent des avantages par rapport aux méthodes existantes, ont déclaré les chercheurs. Tout d’abord parce qu’elles mettent en jeu un vaste ensemble d'images cliniques en milieu hospitalier, par l’échantillonnage d’un ensemble divers de cas ensuite, et enfin parce que des métriques ajustées en fonction de la population donnent des résultats plus représentatifs et comparables. « Nous pensons que l'échantillonnage de données utilisé dans ce travail permet de représenter plus précisément l'incidence de ces affections, a déclaré le Dr Tse. À l'avenir, le deep learning peut constituer une ressource utile pour faciliter le développement continu de modèles d'intelligence artificielle cliniquement utiles pour la radiographie thoracique. »

L’équipe de recherche a mis à la disposition des chercheurs les étiquettes d’évaluation des milliers d’images du NIH à l’adresse suivante: https://cloud.google.com/healthcare/docs/resources/public-datasets/nih-chest#. additional_labels. « La base de données du NIH est une ressource très importante, mais les étiquettes actuelles sont bruyantes, ce qui rend difficile l'interprétation des résultats publiés sur ces données, a déclaré Shetty. Nous espérons que la publication de nos étiquettes contribuera à la poursuite des recherches dans ce domaine. »

SUR LE MÊME THÈME

Trouver le modèle qui puisse efficacement intégrer l'IA dans le flux de travail du radiologue

Le médecin-chercheur Eric J. Topol et le spécialiste en IA de Harvard, Pranav Rajpurkar plaident en faveur d'une séparation claire des rôles entre les systèmes d'IA et les radiologues dans un éditorial publié dans la Revue Radiology. Ils proposent un cadre que les radiologues doivent adapter à leurs...

28/08/2025 -

Un acteur français de l'IA propose deux outils TDM pour la détection du cancer

Gleamer, acteur française de l’IA médicale, a lancé en juillet dernier sa suite OncoView destinée à assister les radiologues dans la détection précoce du cancer par densitométrie (TDM).

22/08/2025 -

Un réseau de radiologues français conclut un accord avec un fournisseur d'IA pour le diagnostic

Gleamer a annoncé, le 10 Juillet 2025, la signature d’un partenariat stratégique avec le réseau France Imageries Territoires (FIT) pour le déploiement des solutions Gleamer Copilot® dans l’ensemble des centres d’imagerie du réseau FIT.

29/07/2025 -

Les comptes rendus radiologiques ne sont pas près de passer par GPT-4

Les grands modèles de langage multimodaux seraient-ils capables de réaliser des comptes rendus radiologiques ? Des résultats d’essais contradictoires troublent le ressenti sur les possibilités de GPT-4V, un modèle qui se concentre uniquement sur la précision diagnostique. Une étude publiée dans la R...

21/07/2025 -

Un nouvel outil d'extraction de données spécialisé en radiologie

Les méthodes d’élaboration des grands modèles de langage sont basées sur des règles qui ne traitent pas efficacement les données non standardisées. Des chercheurs britanniques présentent, dans un article publié dans la Revue European Radiology, RADEX, le nouvel outil d’extraction de données radiolog...

15/07/2025 -

Des grands modèles de langage sensés participer à l'annotation des images pour le deep learning

Incontournables pour l’entrainement des modèles de deep learning, les annotations d’images radiologiques sont rébarbatives et chronophages pour les experts qui les créent. Des grands modèles de langage (LLM) pourraient remplacer les annotations humaines, comme l’indique un article scientifique publi...

23/06/2025 -

Les bonnes pratiques pour l'évaluation de la pertinence d'un outil d'IA en imagerie

Radiologues, informaticiens et chercheurs présentent, dans un article publié dans la Revue Radiology, les pièges et les meilleures pratiques pour atténuer les biais des modèles d'intelligence artificielle (IA) en imagerie médicale. Ils présentent une sorte de feuille de route pour des pratiques plus...

13/06/2025 -

LETTRE D'INFORMATION

Ne manquez aucune actualité en imagerie médicale et radiologie !

Inscrivez-vous à notre lettre d’information hebdomadaire pour recevoir les dernières actualités, agendas de congrès, et restez informé des avancées et innovations dans le domaine.