Des LLM affinés pour aider à la relecture des comptes rendus

Selon une nouvelle étude publiée dans la Revue Radiology, un grand modèle de langage (LLM) améliorerait sensiblement la détection des erreurs dans les comptes rendus de radiologie. Les chercheurs ont utilisé des comptes rendus synthétiques et des données ciblées pour donner au LLM de la légèreté.

Les comptes rendus de radiologie peuvent être compromis par des facteurs tels que les erreurs des logiciels de reconnaissance vocale, la variabilité des processus perceptifs et interprétatifs, et les biais cognitifs. Ces erreurs peuvent entraîner des diagnostics erronés ou des retards de traitement, d'où l'urgence de disposer de comptes rendus de qualité.

Les LLM affinés sont-ils pertinents pour aider les radiologues dans la relecture des comptes rendus ?

Les LLM comme ChatGPT, qui offrent un potentiel important en relecture, renforcent à ce titre leur pertinence dans le domaine médical, notamment pour la détection des erreurs dans les comptes rendus de radiologie, mais ils restent sous-explorés.

Les LLM comme ChatGPT, qui offrent un potentiel important en relecture, renforcent à ce titre leur pertinence dans le domaine médical, notamment pour la détection des erreurs dans les comptes rendus de radiologie, mais ils restent sous-explorés.

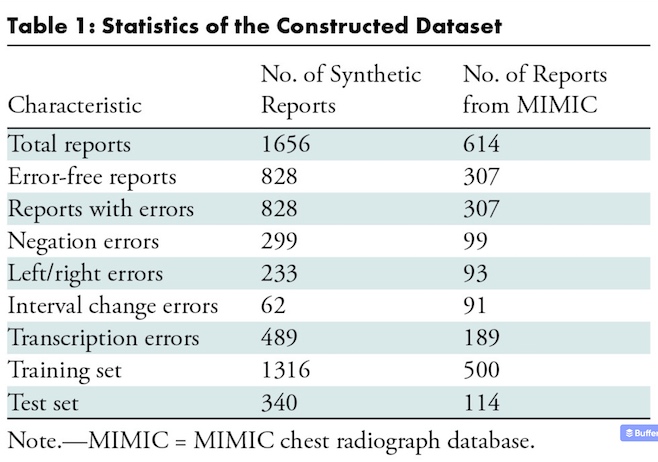

Pour combler ce manque de connaissances, des chercheurs américains ont évalué des LLM affinés - pré-entraînés puis entraînés sur des données spécifiques à un domaine - pour détecter les erreurs dans les comptes rendus de radiologie lors de la relecture médicale. Ils ont consigné leur travail dans un article publié dans la Revue Radiology.

En vous abonnant à Thema Radiologie, vous débloquez l’accès à l’ensemble de nos contenus premium : dossiers thématiques, tribunes d’experts, analyses technologiques, interviews et décryptages réglementaires.

Profitez de 15 jours d'essai gratuit pour découvrir tous nos contenus premium !

Déjà abonné ? Connectez-vous pour débloquer cet article.

SUR LE MÊME THÈME

Une solution d'aide au diagnostic validée par la FDA pour le dépistage du cancer du poumon

Median Technologies vient d'annoncer avoir obtenu l’autorisation de la FDA pour eyonis® LCS, le premier logiciel dispositif médical de détection et diagnostic basé sur l’IA pour le dépistage du cancer du poumon.

10/02/2026 -

Un modèle de segmentation des images IRM obtient le Prix Alexander Magulis 2025

Après la tomodensitométrie, c’est au tour des images IRM de bénéficier de la segmentation automatisée. TotalSegmentator MRI, un modèle entraîné à la fois sur des images IRM et TDM, a remporté le Prix Alexander R. Margulis 2025 de la RSNA. Il s’agit d’un outil très précis permettant notamment d’obten...

02/12/2025 -

Un assistant clinique IA qui optimise le workflow médical

Microsoft vient d’annoncer la disponibilité en France de Microsoft Dragon Copilot, un assistant clinique IA conçu pour simplifier la documentation, faciliter la recherche d’informations et automatiser des tâches.

08/10/2025 -

Comment la DRIMbox améliore la qualité et la pertinence des examens d'imagerie

Le programme Ségur Vague 2 pour l’imagerie connaît aujourd’hui son premier point d’étape avec l’enregistrement définitif des candidats au référencement RIS et DRIMbox. Nous avons rencontré Jean-Marc Chevilley, Directeur de Projet au sein de la Délégation au Numérique en Santé, qui est le pilote prin...

07/10/2025 -

Dr Data accélère l’IA et la recherche grâce au e-consentement en radiologie

Depuis la publication de l'AI Act, l'écosystème de l’imagerie médicale doit se préparer à évoluer, notamment pour gérer le consentement et l’opposition des patients. L'équipe de Dr Data a mis à disposition son expertise en protection des données de santé pour construire une solution et des processus...

04/10/2025 -

Trouver le modèle qui puisse efficacement intégrer l'IA dans le flux de travail du radiologue

Le médecin-chercheur Eric J. Topol et le spécialiste en IA de Harvard, Pranav Rajpurkar plaident en faveur d'une séparation claire des rôles entre les systèmes d'IA et les radiologues dans un éditorial publié dans la Revue Radiology. Ils proposent un cadre que les radiologues doivent adapter à leurs...

28/08/2025 -

Un acteur français de l'IA propose deux outils TDM pour la détection du cancer

Gleamer, acteur française de l’IA médicale, a lancé en juillet dernier sa suite OncoView destinée à assister les radiologues dans la détection précoce du cancer par densitométrie (TDM).

22/08/2025 -

LETTRE D'INFORMATION

Ne manquez aucune actualité en imagerie médicale et radiologie !

Inscrivez-vous à notre lettre d’information hebdomadaire pour recevoir les dernières actualités, agendas de congrès, et restez informé des avancées et innovations dans le domaine.