Des GML non pertinents pour les tâches cliniques complexes

L'utilisation de grands modèles de langage (GML) accessibles au public pour des tâches cliniques complexes peut engendrer un effet négatif sur la prise en charge des patients, selon une nouvelle étude internationale publiée dans la Revue Radiology. Les résultats de l’étude soulignent la nécessité de réglementer ces GML dans des scénarios qui nécessitent un raisonnement médical de haut niveau.

Les GML, élaborés par l’intelligence artificielle (IA) et génériques accessibles au public comme ChatGPT (GPT 3.5 et GPT-4) et Google Gemini (anciennement Bard), montrent des résultats prometteurs dans certaines tâches, notamment en imagerie médicale. Ils ont déjà été testés dans une grande variété de tâches cliniques, du traitement des formulaires de demande de radiologie aux guides pratiques, en passant par l'aide au diagnostic.

Quel potentiel les GML présentent-ils pour des tâches cliniques complexes ?

Mais ces GML réussissent moins bien dans des tâches plus complexes nécessitant un niveau de raisonnement plus élevé et des connaissances cliniques plus approfondies, comme la formulation de recommandations des pratiques d’imagerie. Les utilisateurs qui recherchent un avis médical ne comprennent pas toujours les limites de ces programmes insuffisamment formés.

En vous abonnant à Thema Radiologie, vous débloquez l’accès à l’ensemble de nos contenus premium : dossiers thématiques, tribunes d’experts, analyses technologiques, interviews et décryptages réglementaires.

Profitez de 15 jours d'essai gratuit pour découvrir tous nos contenus premium !

Déjà abonné ? Connectez-vous pour débloquer cet article.

SUR LE MÊME THÈME

L'échographie de contraste pour différentier les tumeurs ovariennes

L’échographie de contraste est pertinente pour différentier les tumeurs ovariennes bénignes et malignes. C’est ce que cherche à prouver une étude, publiée dans l’American Journal of Roentgenology (AJR) qui classe les lésions selon les critères O-RADS et des scores CEUS. Cette approche pourrait cont...

20/02/2026 -

Physiologie de la grossesse et du post-partum explorée par l'imagerie

La Revue RadioGraphics propose un recueil radiographique de la physiologie de la grossesse et du post-partum, ainsi que de leurs variantes pathologiques. Cet article recommande notamment de ne pas confondre vascularisation myométriale accrue et malformation artério-veineuse au cours de cette transfo...

10/02/2026 -

La Cour des comptes épingle la politique publique sur le cancer du sein

La Cour des comptes confirme, dans un rapport récent, le taux de participation au dépistage organisé du cancer du sein inférieur à 50%. Elle observe notamment des dépenses de soins qui augmentent plus que le nombre de patientes traitées, ainsi qu’un suivi post-thérapeutique insuffisant par manque de...

02/02/2026 -

Un prototype d'imagerie thermique pour évaluer la marge opératoire du sein

La qualité du traitement chirurgical du cancer du sein est conditionnée par l’obtention d’une résection avec marges négatives. Pour évaluer précisément ces marges, l’imagerie thermique peropératoire a un fort potentiel. Un prototype de caméra thermique a été expérimenté pour prédire les résections à...

19/01/2026 -

Une revue exhaustive des indications d'IRM pelvienne gynécologique

Un article récent publié dans la Revue RadioGraphics nous propose une revue de l’ensemble des indications d’IRM pelvienne gynécologique. Ce document décrit l’arsenal complet de séquences en T1, T2 et diffusion à utiliser, promeut une approche systématique et progressive de l’évaluation des lésions e...

12/01/2026 -

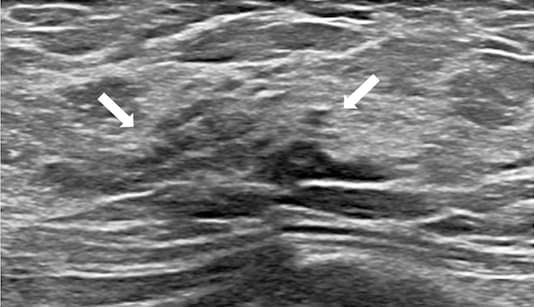

Un agrément inter-observateurs pour diagnostiquer les nodules mammaires

Les lésions nodulaires malignes mammaires sont jugées comme difficilement standardisées dans BI-RADS. Une étude coréenne publiée dans la Revue Radiology tente de faire une comparaison avec les lésions non tumorales et observe une bonne concordance inter-observateurs pour le classement en lésions neu...

16/12/2025 -

Une stratification plus robuste du risque de cancer du sein avec l'IA

Un modèle d'IA basé uniquement sur l'analyse d'images pour prédire le risque de cancer du sein à cinq ans offre une stratification du risque plus robuste que l'évaluation de la densité mammaire seule. Des chercheuses ont présenté ce modèle, capable d’identifier les changements dans le tissu mammaire...

04/12/2025 -

LETTRE D'INFORMATION

Ne manquez aucune actualité en imagerie médicale et radiologie !

Inscrivez-vous à notre lettre d’information hebdomadaire pour recevoir les dernières actualités, agendas de congrès, et restez informé des avancées et innovations dans le domaine.